2014年9月18日,苏格兰居民将进行公民投票决定是否独立于英国。

2014年9月18日,苏格兰居民将进行公民投票决定是否独立于英国。由于上周进行了一系列民意调查,结果略有不同,我决定对其进行简单的Meta分析。根据现有证据,调查结果,估计当前的状态。

可下载资源

数据

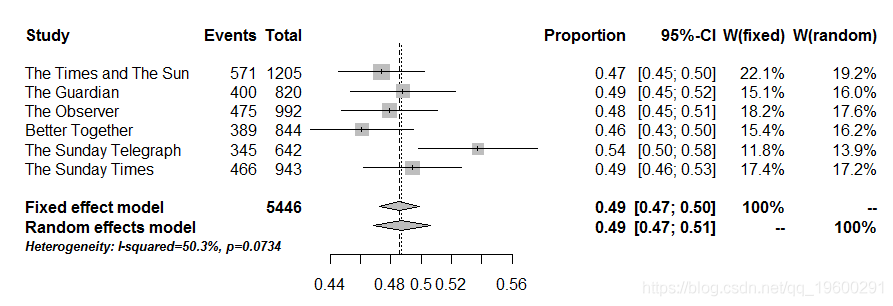

包括从9月14日进行的最后六次投票,网站给出的数据whatscotlandthinks.org。如下所示。

| 民意调查开始 | 民意调查结束 | 选民数量 | 同意 |

|---|---|---|---|

| 2014年9月9日 | 2014年11月9日 | 1205 | 571 |

| 2014年9月9日 | 2014年11月9日 | 820 | 400 |

| 2014年9月9日 | 2014年11月9日 | 992 | 475 |

| 2014年10月9日 | 2014年12月9日 | 844 | 389 |

| 2014年10月9日 | 2014年12月9日 | 642 | 345 |

| 2014年10月9日 | 2014年12月9日 | 943 | 466 |

固定效应(fixed effect, FE)vs. 随机效应(random effect, RE)是统计学中躲不开的一对重要概念,也是统计学思想的一个非常核心的理念:

真实世界的复杂现象 = 确定的统计模型 + 不确定的随机误差

虽然在特定的统计方法中,大家或多或少能区分什么是固定效应、什么是随机效应,但是由于不同的统计方法(甚至不同的学科)对FE和RE的界定不尽相同,所以当你接触到更多的统计方法之后,很可能将不同模型的FE和RE搞混淆。

理解透彻FE和RE并不容易,因为这两个词本身并不够descriptive、比较笼统且具有一定的误导性。比如,心理学家和经济学家也许会因为FE和RE的问题“打架”——心理学家可能会说“我们更推荐用随机效应模型(random-effects model)!”,而经济学家可能会说“我们基本都用固定效应模型(fixed-effect model)!”。但实际上,在各自熟悉的知识框架下理解FE和RE,就如同“盲人摸象”,双方可能都只看到了冰山一角。正因为不同学科有着不大一致的话语体系,我们更需要从一个综合的视角来深入理解这一对贯穿了很多统计模型的基本概念——FE和RE。

1 / 总框架:回归分析

「回归(regression)」不仅是众多统计方法的本质,更是我们理解这个复杂世界的重要思想工具。世界很复杂,但在科学的视角下,很多现象或行为都可以被简化为回归模型——现象或行为本身是“观测项”,我们还会用一系列其他变量来解释或预测这个观测项,其中,一部分是我们能够预测的“结构项”,另一部分则是我们暂时无法预测的“误差项”。

-

结构项是由一些变量(X1、X2…)及参数(b0、b1…)组成的,尽管我们无法穷尽所有可能的预测变量,但至少我们可以从已知的变量关系中发现一些规律,于是结构项就构成了回归模型的“固定部分”。

-

误差项则是我们为了简化模型而不得不舍弃的一部分,这种刻意的忽略是不可避免的,否则就会造成“过拟合”(overfitting)。具体来说,误差项又有三个来源:遗漏的变量、测量的误差、随机的干扰。但无论如何,我们终究要在“精确性”(accuracy)和“简约性”(parsimony)之间做出权衡,从而舍弃一部分信息,这些“剩下来”的未被解释的信息就构成了回归模型的“随机部分”。

一般而言,回归模型的“随机部分”需要尽可能服从正态分布,这样才能保证“固定部分”的参数估计是无偏的、一致的、有效的。

“回归”的思想其实渗透着“舍得”的理念:我们通过舍弃那些“随机部分”的误差(residual variance),获得了我们想要的“固定部分”的参数(regression coefficients)。

2 / 多层线性模型(HLM)

如果说回归是众多统计方法的本质,那么多层线性模型(Hierarchical Linear Model, HLM)就可以视为众多统计方法的“幕后主谋”——回归分析的最一般形式可以归为HLM。

当然,这只是一种理念层面的说法,只是有助于我们综合理解很多不同的统计方法。实际上,HLM并不能真正代表和直接实现所有的统计方法。不过,在充分理解了HLM的原理之后再去理解其他统计方法就会比较轻松,尤其是在理解固定效应FE和随机效应RE这件事情上。

在HLM的话语体系中,我们不太直接说FE和RE,因为这两个词对于HLM而言太过于笼统,HLM有着更为细致的划分:

注:每段后面附的语句均为R语言的回归方程表达式,~的前后分别为结果变量和预测变量,例如Y ~ 1 + X1 + X2,其中表示截距的“1”可以省略。另外,在以下的示例中,Y、X1和X2都是Level 1变量(顺带一提,因变量Y只能是Level 1变量,不能是Level 2变量)。

-

固定截距(fixed intercept):固定截距其实并不存在于HLM的模型中,而是“降级”到了一般的最小二乘法回归(OLS),也就是我们最常用的GLM回归分析。

→ lm(Y ~ 1 + X1 + X2, …) -

随机截距(random intercept):在做HLM时,我们通常都会将截距设置为随机截距,也就是允许不同组具有各自的截距(基线水平)。可以理解为,“有的人出生就在终点,而你却在起点”。在R里面,只要你在回归表达式后面加上小括号(当然,这时就不能再用lm了,要用lme4和lmerTest包的lmer函数),括号里就定义了Level 1截距或斜率在Level 2的随机部分(Level 1的随机部分则是个体层面的残差residual,不用我们定义)。竖线“|”后面是分组变量(clustering/grouping variable,可以是省市、学校,而在重复测量、追踪设计中则是被试个体),竖线前面的1代表随机截距、具体变量名则代表这个变量对应的随机斜率。

→ lmer(Y ~ 1 + X1 + X2 + (1 | group), …) -

固定斜率(fixed slope):固定斜率的意思是,某个Level 1自变量的斜率在不同的group里面都是一致的。虽然实际情况未必真的一致,但研究者可以假设并检验斜率是否在组间保持一致而不存在显著差异。需要注意的是,Level 2截距或斜率并不存在固定和随机的区分(或者说都是固定的),除非还有Level 3。

→ lmer(Y ~ 1 + X1 + X2 + (1 | group), …) -

随机斜率(random slope):与固定斜率相反,随机斜率意味着某个Level 1自变量的斜率在不同的group之间存在差异,或者说“依组而变”。可以理解为,“有的人花两个小时就能赚10000,而你却只能挣个10块钱被试费”。你既可以只纳入随机斜率成分而不对斜率的差异作出具体解释,也可以再纳入一个Level 2的自变量与这个Level 1自变量发生交互作用(即跨层交互),从而解释为什么X的效应依组而变、是什么因素导致了这种变化。

→ lmer(Y ~ 1 + X1 + X2 + (1 + X1 | group), …) # 这里的1可以省略,默认都纳入截距(但只有随机截距时则不能省)

→ lmer(Y ~ 1 + X1*W + X2 + (1 + X1 | group), …) # W表示一个Level 2解释变量,X1*W即为一个跨层交互作用

一般来说,只要使用HLM,都会考虑随机截距。所以,在HLM的框架下探讨FE还是RE,更多的是指「斜率」为固定还是随机。

那么,何时使用固定斜率、何时使用随机斜率呢?主要有以下4个考虑因素:

-

理论假设:我们一般不会特意假设存在随机斜率,也就是说,设置随机斜率需要有比较强的理论假设认为Level 1自变量的效应依组而变。这一点也可以进行统计检验,如果斜率的随机部分(方差成分)与零没有显著差异,则可以考虑舍弃随机斜率。

-

研究目的:如果我们的研究目的就是想检验是否存在跨层交互作用,那么相应的Level 1自变量就需要设置为随机斜率。这一点容易理解,因为跨层交互本身就意味着X的斜率会变、并且我们还想解释为什么会变,如果你不设置为随机斜率,岂不自相矛盾?

-

Level 2的组数量:如果Level 2的组数量过少(如<10组),则Level 2的自由度过小,不足以做出稳健的参数估计,因此更适合用固定斜率。——BUT!如果Level 2的组数量真的小于10,我们甚至需要仔细斟酌一下是否还要用HLM!因为Level 2的组别也是一种随机取样,在GLM里面我们一般要求样本量至少是变量数的10倍,在HLM里面我们同样会要求组别不能太少,一般要求Level 2至少达到10~20组以上,否则Level 2分模型的统计检验力power就会严重不足!这一点和GLM是一样的!——所以,如果没有10组以上的取样,最好还是不要用HLM,此时我们要改用所谓的“固定截距”模型,即降级到GLM / ANOVA / ANCOVA!

-

Level 2每组内的样本量:联想到经典的被试间设计ANOVA,我们一般要求每组样本量不能太少,至少要30~50名被试才能保证power。这一点同样适用于HLM。如果Level 2每组内的样本量都过小(如<30),虽然仍旧可以使用HLM,但为了得到更稳健的参数估计,需要借助更多乃至所有的数据信息,因此更适合用随机斜率。

总结

所谓“固定效应”和“随机效应”都是不太精确的描述,甚至有一定的误导性,因为在不同的统计模型里,它们所指的具体方法甚至可能大相径庭。而借助HLM里面最基本的对「固定 vs. 随机」「截距 vs. 斜率」的2 × 2区分,我们可以清楚地看到:

-

GLM / OLS回归及其特例ANOVA / ANCOVA都属于“固定截距、固定斜率”模型,其随机部分只有个体层面的残差(residual)。

-

HLM首先属于“随机截距”模型,至于采用“固定斜率”还是“随机斜率”,则综合取决于理论假设、研究目的、样本量是否充足等等。相比于GLM,HLM的随机部分不仅有Level 1个体的残差,还多了Level 1截距/斜率的误差。

-

Panel model无论FE还是RE都属于“异质性截距”模型——但对于FE,截距的异质性是“固定”的(不要求残差服从正态分布,且允许截距与自变量相关,但在HLM里面并无对应的等价模型,反而属于一种OLS回归);而对于RE,截距的异质性是“随机”的(要求残差服从正态分布,等价于HLM“随机截距”模型)。总体来说,Panel model大多采用FE模型(异质性[非随机]截距)。

-

Meta-analysis里面的FE和RE分别对应于HLM的“固定斜率”和“随机斜率”,不过这里的“斜率”应理解为元分析不同Study的效应量。效应量本身可以看做是Level 1的斜率,而效应量的标准误则对应于Level 1(组内)的残差。总体来说,Meta-analysis大多采用RE模型(即HLM的随机斜率模型)。

分析

用R进行分析。此函数结合被调查的数量,以给出对选民同意平均比例的总体估计。进行两项分析,一项是所谓的固定效应分析,第二项是随机效应分析。

来自不同研究的95%置信区间与每个基本样本点重叠,说明了在每个研究中给出(相对)小数量的点,结果的微小差异可能纯粹是由于抽样误差。

这里提出的简单分析存在许多缺陷。

荟萃分析就好像随机抽样一样。事实上,民意调查样本是使用更复杂的调查设计方法构建的,并且可能不应该像我所做的那样进行分析(就像它们是简单的随机样本一样)。

R输出

对于那些感兴趣的人,如下所示是分析的R输出,给出每个民意调查的比例,每个民意调查的95%CI,分配给每个民意调查的权重(在固定和随机效应分析中),估计I ^ 2(可归因于真实异质性的变异比例)。

proportion 95%-CI %W(fixed) %W(random)

The Times and The Sun 0.4739 [0.4453; 0.5025] 22.12 19.16

The Guardian 0.4878 [0.4531; 0.5226] 15.09 15.99

The Observer 0.4788 [0.4473; 0.5104] 18.23 17.57

Better Together 0.4609 [0.4269; 0.4952] 15.44 16.19

The Sunday Telegraph 0.5374 [0.4979; 0.5765] 11.75 13.94

The Sunday Times 0.4942 [0.4618; 0.5266] 17.36 17.16

Number of studies combined: k=6

proportion 95%-CI z p.value

Fixed effect model 0.4859 [0.4726; 0.4991] NA --

Random effects model 0.4872 [0.4682; 0.5062] NA --

Quantifying heterogeneity:

tau^2 = 0.0045; H = 1.42 [1; 2.25]; I^2 = 50.3% [0%; 80.3%]

Test of heterogeneity:

Q d.f. p.value

10.07 5 0.0734

Details on meta-analytical method:

- Inverse variance method

- DerSimonian-Laird estimator for tau^2

- Logit transformation

- Clopper-Pearson confidence interval for individual studies

R语言拟合线性混合效应模型、固定效应、随机效应参数估计可视化生物生长、发育、繁殖影响因素

R语言拟合线性混合效应模型、固定效应、随机效应参数估计可视化生物生长、发育、繁殖影响因素 【视频】因子分析简介及R语言应用实例:对地区经济研究分析重庆市经济指标

【视频】因子分析简介及R语言应用实例:对地区经济研究分析重庆市经济指标 R语言宏观经济学:IS-LM曲线可视化货币市场均衡

R语言宏观经济学:IS-LM曲线可视化货币市场均衡 R语言代做编程辅导和解答GLM Coursework

R语言代做编程辅导和解答GLM Coursework